New

Marknadsförare

Stärka ditt team att skapa

videor i skala

Byrån

Skala videoproduktion med

enkelt

WAN 2.2 är en öppen källkod generativ AI videomodell från Alibabas Damo Academy, offentligt släppts den 28 juli 2025. Den introducerar en blandning av experter (MoE) arkitektur i videofuffingsmodellen, vilket betydligt förbättrar modellkapacitet och prestanda utan att höja konklusionskostnaderna. Modellen är anmärkbar för sin cinematiska estetik, högdefinitionsproduktion 1080p och förmågan att generera komplexa vätskrörelse med större kontroll än tidigare modeller.

WAN 2.2 är en öppen källkod generativ AI videomodell från Alibabas Damo Academy, offentligt släppts den 28 juli 2025. Den introducerar en blandning av experter (MoE) arkitektur i videofuffingsmodellen, vilket betydligt förbättrar modellkapacitet och prestanda utan att höja konklusionskostnaderna. Modellen är anmärkbar för sin cinematiska estetik, högdefinitionsproduktion 1080p och förmågan att generera komplexa vätskrörelse med större kontroll än tidigare modeller.

Skapar komplexa, vätskade och naturliga rörelser i videor, förbättrar realismen och sammanhållningen.

Tränad på noggrant kurerade data för att producera videor med exakt kontroll över belysning, färg och sammansättning.

Generera videor med nativ 1080p upplösning på 24fps, lämpliga för professionell användning.

Filmkameranordning Generera videor med nativ 1080p upplösning på 24fps, lämpliga för professionell användning.

Skapar sömlösa videoövergångar genom att interpolera mellan en angiven start- och slutram.

En högkomprimerad 5B-modell finns tillgänglig som kan köra på konsumentprocesserna som en RTX 4090.

Modellen är allmänt tillgänglig och möjliggör finjustering med Lora och andra gemenskapsutvecklade verktyg.

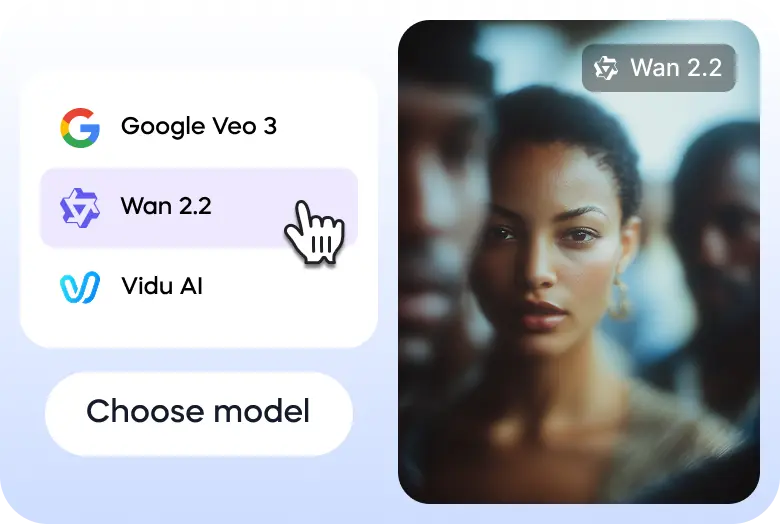

Här är tre enkla steg för att hjälpa dig att utforska WAN 2.2 på Vizard:

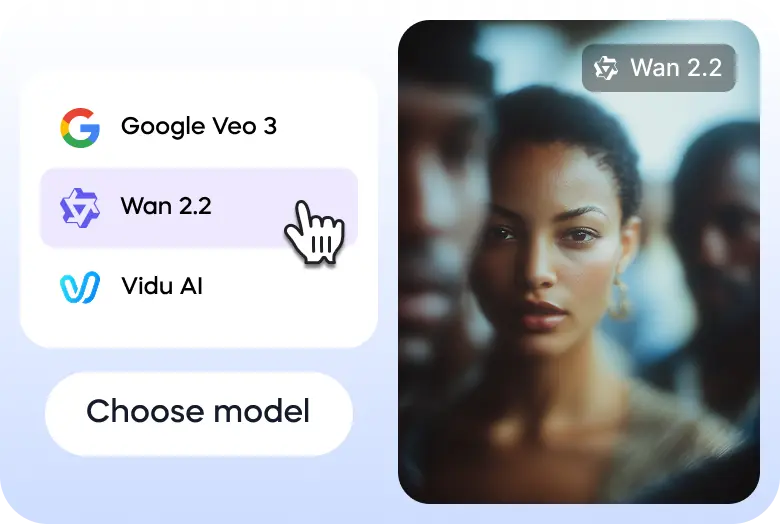

Gå till Vizards text till videogenerator och välj WAN 2.2 modell.

Ange din prompt eller ladda upp din bild för att starta.

När videon är klar kan du ladda ner den eller dela den på dina sociala mediakonton direkt via Vizard.

Wan2.2 The quality is significantly improved, tested some human body performance. Amazing@Alibaba_Wan #wan2.2 pic.twitter.com/ptUXlOS1Ka

— TTPlanet (@ttplanet) July 28, 2025

Fun workflow I was playing with last night

— A.I.Warper (@AIWarper) August 8, 2025

1) Kontext to remove Thor from the shot

2) Photopea to place Shrek

3) Kontext + Relight lora to blend him into the shot

4) Wan2.2 i2V to animate

Very addicting... 😍

Prompts are written up in the corner. Wan 2.2 prompt below 👇 pic.twitter.com/EnWE2OgA7T

Wan2.2(I2V) works pretty good.(Base image is not AI generated.) pic.twitter.com/5g9CfoiqT4

— Xiu Ran (@f_fanshu) July 30, 2025

You can’t skate here sir..

— Ingi Erlingsson 🪄 (@ingi_erlingsson) August 5, 2025

Wan2.2 @Alibaba_Wan + @ComfyUI 🛹 pic.twitter.com/kFaKeoKYNi

I hope you are enjoying your summer 🍸⛱️

— Julian Bilcke (@flngr) July 28, 2025

Because open source AI video is back 💪

Wan2.2 is out!✨ pic.twitter.com/9feAXVC4Hi

Tried doing a wall punching effect using the new Wan2.2 open source model. @Alibaba_Wan @ComfyUI pic.twitter.com/PGKoZmpuso

— enigmatic_e (@8bit_e) July 31, 2025

Tried the Veo3 annotation trick with Wan2.2 14B, 8 steps pic.twitter.com/x8Lnmcx1wg

— Linoy Tsaban (@linoy_tsaban) July 29, 2025

Vad är WAN 2.2?

WAN 2.2 är en toppmodell, generativ AI videomodell som utvecklats av Alibabas Damo Academy. Det är en stor uppgradering till den grundläggande WAN videomodellserien, utformad för att skapa högkvalitativa filmvideor från text- och bilduppdrag. Modellen är känd för sin avancerade rörelsens generation och estetiska kontroller.

Vilka versioner finns tillgängliga?

WAN 2.2 finns i flera versioner med olika funktioner. Kärna med öppen källmodeller innehåller den effektiva Ti2V-5B-modellen, som stöder både text-to-video (T2V) och bild-to-video (I2V) med 720p upplösning och kan köra på konsumentkvalitetsprocesser. Det finns också kraftfulla 14B-modeller, t.ex. T2V-A14B och i2V-A14B, som använder en MoE arkitektur för högre kvalitet och prestanda, lämplig för mer robust maskinvara.

Vad gör det unik?

WAN 2.2 framgår av sin innovativa Mix-of-experts arkitektur, som skiljer aviseringsprocessen i specialiserade stadier för bättre prestanda utan en betydande ökning av beräkningskostnaderna. Den har också cinematiska estetiska kontroller, en förmåga att generera komplex och vätskap rörelse och en första-sista frame-till video (FLF2V) funktion som skapar smidiga övergångar mellan två bilder. Dess open source naturen gör det möjligt att finjustera och integrera gemenskapsdriven.

Är det säker att använda?

Som en öppen källkod beror säkerheten för WAN 2.2 i stor utsträckning på hur den implementeras och används. Utvecklarna har fastställt en användningspolitik som förbjuder generering av olagligt, skadligt eller vilseledande innehåll. Samtidigt som modellen inte har ett inbyggd innehållsmoderat system förväntas utvecklare och plattformar som använder WAN 2.2 genomföra sina egna garantier för att säkerställa ansvarsfull användning och efterlevnad av rättsliga och etiska standarder.

Hur snabbt är det?

WAN 2.2 är mycket optimerad för hastighet, särskilt dess Ti2V-5B-modell, som är en av de snabbaste tillgängliga med 720p upplösning och 24fps. En 5-sekunders video kan genereras på bara några minuter på en konsumentGPU som en RTX 4090, med kraftfulla maskinvara som erbjuder ännu snabbare resultat. Snabbheten ökar ytterligare genom sin effektiva blandning av experter (MoE) arkitektur.

Är den tillgänglig via mobil?

WAN 2.2 är främst en utvecklarfokuserad, öppen källkod modell. Den har ingen officiell, dedikerad mobilapp från sin producent. Men eftersom det är öppen källkod kan utvecklare integreras i mobilvänliga webbapplikationer eller skapa sina egna mobilapplikationer. Dess konsumentkvalitet GPU-kompatibilitet gör det också mer tillgänglig för användare med högklassiga mobilarbetsstationer.

Vad kan den generera eller skapa?

WAN 2.2 kan generera ett brett utbud av videoinnehåll, från kortformliga annonser och sociala medier till filmscener och animationer. Dess funktioner inkluderar text-to-video, bild-to-video och bild-baserad in-målning. Användarna kan generera videor med specifika kamerörörelser, exakta estetiska stilar och realistiska rörelser för tecken och objekt, vilket gör det till ett mångsidigt verktyg för både tekniska och kreativa projekt.

Hur kan det användas?

Det vanligaste sättet att använda WAN 2.2 är genom att ladda ner modellfilerna och köra dem lokalt på en kompatibel maskin, ofta med integration via plattformar som Comfyui eller diffuser. För en mer tillgänglig upplevelse finns modellen via molnAPI-leverantörer. Det finns också möjlighet att prova WAN 2.2 gratis via Vizard plattformen, som ger ett online-gränssnitt för att experimentera med modellens funktioner.

WAN 2.2 är en öppen källkod generativ AI videomodell från Alibabas Damo Academy, offentligt släppts den 28 juli 2025. Den introducerar en blandning av experter (MoE) arkitektur i videofuffingsmodellen, vilket betydligt förbättrar modellkapacitet och prestanda utan att höja konklusionskostnaderna. Modellen är anmärkbar för sin cinematiska estetik, högdefinitionsproduktion 1080p och förmågan att generera komplexa vätskrörelse med större kontroll än tidigare modeller.

Skapar komplexa, vätskade och naturliga rörelser i videor, förbättrar realismen och sammanhållningen.

Tränad på noggrant kurerade data för att producera videor med exakt kontroll över belysning, färg och sammansättning.

Generera videor med nativ 1080p upplösning på 24fps, lämpliga för professionell användning.

Filmkameranordning Generera videor med nativ 1080p upplösning på 24fps, lämpliga för professionell användning.

Skapar sömlösa videoövergångar genom att interpolera mellan en angiven start- och slutram.

En högkomprimerad 5B-modell finns tillgänglig som kan köra på konsumentprocesserna som en RTX 4090.

Modellen är allmänt tillgänglig och möjliggör finjustering med Lora och andra gemenskapsutvecklade verktyg.

Här är tre enkla steg för att hjälpa dig att utforska WAN 2.2 på Vizard:

Gå till Vizards text till videogenerator och välj WAN 2.2 modell.

Ange din prompt eller ladda upp din bild för att starta.

När videon är klar kan du ladda ner den eller dela den på dina sociala mediakonton direkt via Vizard.

Wan2.2 The quality is significantly improved, tested some human body performance. Amazing@Alibaba_Wan #wan2.2 pic.twitter.com/ptUXlOS1Ka

— TTPlanet (@ttplanet) July 28, 2025

Fun workflow I was playing with last night

— A.I.Warper (@AIWarper) August 8, 2025

1) Kontext to remove Thor from the shot

2) Photopea to place Shrek

3) Kontext + Relight lora to blend him into the shot

4) Wan2.2 i2V to animate

Very addicting... 😍

Prompts are written up in the corner. Wan 2.2 prompt below 👇 pic.twitter.com/EnWE2OgA7T

Wan2.2(I2V) works pretty good.(Base image is not AI generated.) pic.twitter.com/5g9CfoiqT4

— Xiu Ran (@f_fanshu) July 30, 2025

You can’t skate here sir..

— Ingi Erlingsson 🪄 (@ingi_erlingsson) August 5, 2025

Wan2.2 @Alibaba_Wan + @ComfyUI 🛹 pic.twitter.com/kFaKeoKYNi

I hope you are enjoying your summer 🍸⛱️

— Julian Bilcke (@flngr) July 28, 2025

Because open source AI video is back 💪

Wan2.2 is out!✨ pic.twitter.com/9feAXVC4Hi

Tried doing a wall punching effect using the new Wan2.2 open source model. @Alibaba_Wan @ComfyUI pic.twitter.com/PGKoZmpuso

— enigmatic_e (@8bit_e) July 31, 2025

Tried the Veo3 annotation trick with Wan2.2 14B, 8 steps pic.twitter.com/x8Lnmcx1wg

— Linoy Tsaban (@linoy_tsaban) July 29, 2025

Vad är WAN 2.2?

WAN 2.2 är en toppmodell, generativ AI videomodell som utvecklats av Alibabas Damo Academy. Det är en stor uppgradering till den grundläggande WAN videomodellserien, utformad för att skapa högkvalitativa filmvideor från text- och bilduppdrag. Modellen är känd för sin avancerade rörelsens generation och estetiska kontroller.

Vilka versioner finns tillgängliga?

WAN 2.2 finns i flera versioner med olika funktioner. Kärna med öppen källmodeller innehåller den effektiva Ti2V-5B-modellen, som stöder både text-to-video (T2V) och bild-to-video (I2V) med 720p upplösning och kan köra på konsumentkvalitetsprocesser. Det finns också kraftfulla 14B-modeller, t.ex. T2V-A14B och i2V-A14B, som använder en MoE arkitektur för högre kvalitet och prestanda, lämplig för mer robust maskinvara.

Vad gör det unik?

WAN 2.2 framgår av sin innovativa Mix-of-experts arkitektur, som skiljer aviseringsprocessen i specialiserade stadier för bättre prestanda utan en betydande ökning av beräkningskostnaderna. Den har också cinematiska estetiska kontroller, en förmåga att generera komplex och vätskap rörelse och en första-sista frame-till video (FLF2V) funktion som skapar smidiga övergångar mellan två bilder. Dess open source naturen gör det möjligt att finjustera och integrera gemenskapsdriven.

Är det säker att använda?

Som en öppen källkod beror säkerheten för WAN 2.2 i stor utsträckning på hur den implementeras och används. Utvecklarna har fastställt en användningspolitik som förbjuder generering av olagligt, skadligt eller vilseledande innehåll. Samtidigt som modellen inte har ett inbyggd innehållsmoderat system förväntas utvecklare och plattformar som använder WAN 2.2 genomföra sina egna garantier för att säkerställa ansvarsfull användning och efterlevnad av rättsliga och etiska standarder.

Hur snabbt är det?

WAN 2.2 är mycket optimerad för hastighet, särskilt dess Ti2V-5B-modell, som är en av de snabbaste tillgängliga med 720p upplösning och 24fps. En 5-sekunders video kan genereras på bara några minuter på en konsumentGPU som en RTX 4090, med kraftfulla maskinvara som erbjuder ännu snabbare resultat. Snabbheten ökar ytterligare genom sin effektiva blandning av experter (MoE) arkitektur.

Är den tillgänglig via mobil?

WAN 2.2 är främst en utvecklarfokuserad, öppen källkod modell. Den har ingen officiell, dedikerad mobilapp från sin producent. Men eftersom det är öppen källkod kan utvecklare integreras i mobilvänliga webbapplikationer eller skapa sina egna mobilapplikationer. Dess konsumentkvalitet GPU-kompatibilitet gör det också mer tillgänglig för användare med högklassiga mobilarbetsstationer.

Vad kan den generera eller skapa?

WAN 2.2 kan generera ett brett utbud av videoinnehåll, från kortformliga annonser och sociala medier till filmscener och animationer. Dess funktioner inkluderar text-to-video, bild-to-video och bild-baserad in-målning. Användarna kan generera videor med specifika kamerörörelser, exakta estetiska stilar och realistiska rörelser för tecken och objekt, vilket gör det till ett mångsidigt verktyg för både tekniska och kreativa projekt.

Hur kan det användas?

Det vanligaste sättet att använda WAN 2.2 är genom att ladda ner modellfilerna och köra dem lokalt på en kompatibel maskin, ofta med integration via plattformar som Comfyui eller diffuser. För en mer tillgänglig upplevelse finns modellen via molnAPI-leverantörer. Det finns också möjlighet att prova WAN 2.2 gratis via Vizard plattformen, som ger ett online-gränssnitt för att experimentera med modellens funktioner.