New

Marketingfolk

Laget ditt til å lage

-videoer i skala

Skapere

Å bygge sosial tilstedeværelse gjorde lett

Agentur

Skall videoproduksjon med

lett

WAN 2.2 er en generativ AI videomodell fra Alibabas Damo Academy, offentlig utgivet 28. juli 2025. Den introducerer en blanding-ekspert-arkitektur (MoE) i videosiffisjonsmodellen, som forbedrer modellkapacitet og prestasjon betydelig uten å øke inferensiekostene. Modellen er merket for sin filmestetika, høydefinisjonsprodukt 1080p og evnen til å generere komplekse, væskebevegelse med større kontroll enn tidligere modeller.

WAN 2.2 er en generativ AI videomodell fra Alibabas Damo Academy, offentlig utgivet 28. juli 2025. Den introducerer en blanding-ekspert-arkitektur (MoE) i videosiffisjonsmodellen, som forbedrer modellkapacitet og prestasjon betydelig uten å øke inferensiekostene. Modellen er merket for sin filmestetika, høydefinisjonsprodukt 1080p og evnen til å generere komplekse, væskebevegelse med større kontroll enn tidligere modeller.

Lapper komplekse, flytende og naturlige bevegelser i videoer, forbedrer realisme og sammenhæng.

Trent på nøye kurerte data for å produsere videoer med precis kontroll over lys, farge og komposition.

Genererer videoer med nativ 1080p oppløsning ved 24fps, egnet til profesjonell bruk.

Filmkamerastontrol Genererer videoer med nativ 1080p oppløsning ved 24fps, egnet til profesjonell bruk.

Lager sømløse videoovergangen ved å interpolere mellom en angivet start- og endramme.

En høyt komprimert 5B-model er tilgjengelig som kan kjøre på konsument-GPU-er som en RTX 4090.

Modellen er offentlig tilgjengelig, og muliggjør finjustering med Lora og andre samfunnsverktøjer.

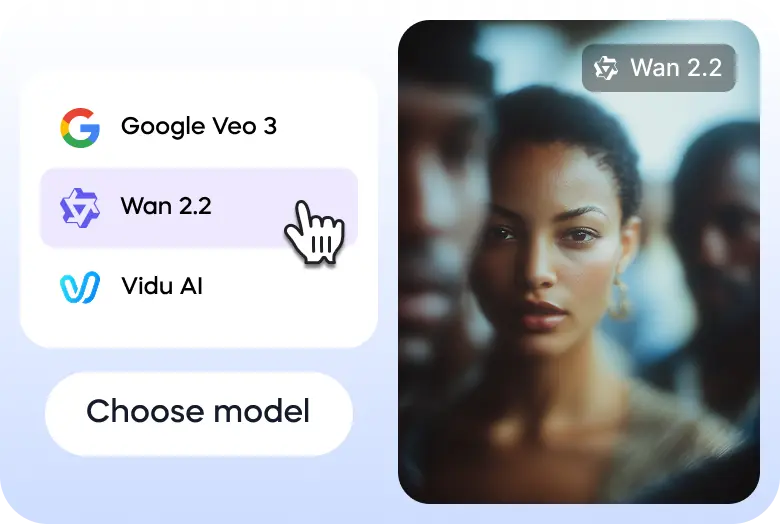

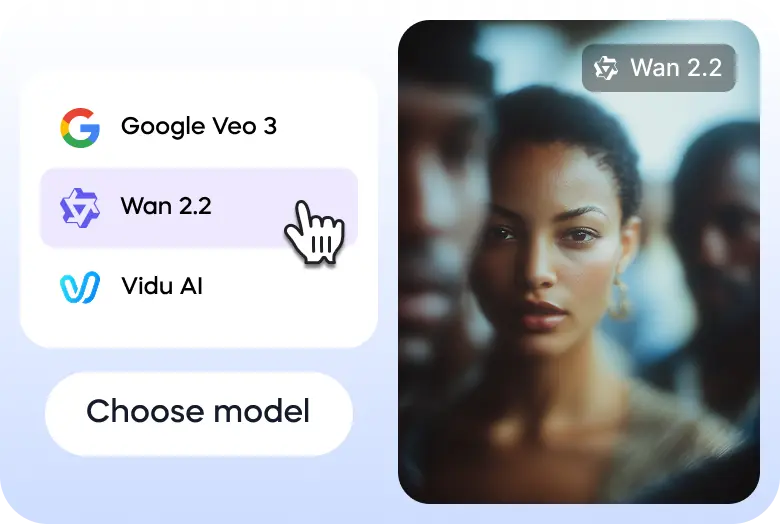

Her er tre enkle trinn som hjelper deg å utforske WAN 2.2 på Vizard:

Gå til Vizards tekst til videogenerator og velg WAN 2.2 modellen.

Innstart eller ladd bildet ditt for å starte.

Når videoen er klar, kan du ladde ned den eller dele den på sosiale mediakontoene direkte via Vizard.

Wan2.2 The quality is significantly improved, tested some human body performance. Amazing@Alibaba_Wan #wan2.2 pic.twitter.com/ptUXlOS1Ka

— TTPlanet (@ttplanet) July 28, 2025

Fun workflow I was playing with last night

— A.I.Warper (@AIWarper) August 8, 2025

1) Kontext to remove Thor from the shot

2) Photopea to place Shrek

3) Kontext + Relight lora to blend him into the shot

4) Wan2.2 i2V to animate

Very addicting... 😍

Prompts are written up in the corner. Wan 2.2 prompt below 👇 pic.twitter.com/EnWE2OgA7T

Wan2.2(I2V) works pretty good.(Base image is not AI generated.) pic.twitter.com/5g9CfoiqT4

— Xiu Ran (@f_fanshu) July 30, 2025

You can’t skate here sir..

— Ingi Erlingsson 🪄 (@ingi_erlingsson) August 5, 2025

Wan2.2 @Alibaba_Wan + @ComfyUI 🛹 pic.twitter.com/kFaKeoKYNi

I hope you are enjoying your summer 🍸⛱️

— Julian Bilcke (@flngr) July 28, 2025

Because open source AI video is back 💪

Wan2.2 is out!✨ pic.twitter.com/9feAXVC4Hi

Tried doing a wall punching effect using the new Wan2.2 open source model. @Alibaba_Wan @ComfyUI pic.twitter.com/PGKoZmpuso

— enigmatic_e (@8bit_e) July 31, 2025

Tried the Veo3 annotation trick with Wan2.2 14B, 8 steps pic.twitter.com/x8Lnmcx1wg

— Linoy Tsaban (@linoy_tsaban) July 29, 2025

Hva er WAN 2.2?

WAN 2.2 er en moderne, open source generativ AI videomodell utviklet av Alibabas Damo Academy. Det er en stor oppgradering til den grundlegende WAN-videodelserien, designet for å lage høykvalitete filmvideoer fra tekst- og billedprop. Modellen er kjent for sin avanserte bevegelsesgenerasjon og estetiske kontroller.

Hvilke versjoner er tilgjengelige?

WAN 2.2 er tilgjengelig i flere versjoner med forskjellige funksjoner. Kernmodellene med åpen source inkluderer den effektive TI2V-5B-modellen, som støtter både tekst-til-video (T2V) og bild-til-video (I2V) ved 720p oppløsning og kan kjøre på GPU-er av forbrugerklasse. Det finnes også mer kraftige 14B-modeller, som T2V-A14B og I2V-A14B, som bruker en blanding av eksperter (MoE) arkitektur for overlegen kvalitet og prestasjon, som passer for mer robust hardware.

Hva gjør det unik?

WAN 2.2 står ut på grunn av sin innovative MoE arkitektur, som skiler avlykningsprocessen i spesialiserte stadier for bedre prestasjon uten en betydelig økning i beregningskostnadene. Den har også estetiske kontroller på filmnivå, en evne til å generere komplekse og væskebevegelse og en første-siste ramme til video (FLF2V) funksjon som skaper glatte overganger mellom to bilder. Dens åpen source gir samfunnsdriven finjustering og integrering.

Er det trygt å bruke?

Som en åpen source-model avhenger sikkerheten til WAN 2.2 i høyhet av hvordan den blir implementert og brukt. Utviklere har etableret en brukspolitik som forbyr generering av ulovlig, skadelig eller vildledende innhold. Selv modellen ikke har et inbygget inneholdsmodereringssystem, forventes utviklere og plattformer som bruker WAN 2.2 å implementere sine egne

Hvor raskt er det?

WAN 2.2 er høyt optimert for hastighet, spesielt sin TI2V-5B-modell, som er en av de raskeste tilgjengelige med 720p oppløsning og 24fps. En 5-sekunds video kan genereres på et par minutter på en forbrugerGPU som en RTX 4090, med mer kraftfulle hardwareopp som tilbyr enda raskere resultater. Hastigheten økes ytterligere av sin effektive blanding of-experts (MoE) arkitektur.

Er den tilgængelig via mobil?

WAN 2.2 er hovedsakelig en utviklerfokusert, open source-model. Den har ingen offisiell, spesielt mobilapp fra sin producent. Men fordi den er open source, kan utviklere integreres det i mobilvennlige nettapplikasjoner eller skape egne mobilapplikasjoner. GPU-kompatibiliteten av konsumentklassen gjør den også mer tilgengelig for brugere med høyt end mobile arbeidstasjoner.

Hva kan den skape eller skape?

WAN 2.2 kan generere en bred utvikling av videoinnhold, fra kortformannonser og sosiale medier til filmscener og animasjoner. Muligheten er tekst-til-video, bild-til-video og bild-basert maling. Brukere kan generere videoer med spesifikke kameravegelser, precisere estetiske stiler og realistiske bevegelser for karakter og objekter, som gjør det til et mångsidig verktøj for både tekniske og kreative projekter.

Hvordan kan det brukes?

Den vanligste måten å bruke WAN 2.2 er å ladde ned modelfilene og kjøre dem lokalt på en kompatible maskin, ofte med integrering via plattformer som Comfyui eller diffuser. For en mer tilgængelig opplevelse er modellen tilgjengelig via skloud API-leverandører. Det fins også muligheten til å prøve WAN 2.2 gratis gjennom Vizard plattformen, som gir et online-grænseff til å eksperimentere med modellens muligheter.

WAN 2.2 er en generativ AI videomodell fra Alibabas Damo Academy, offentlig utgivet 28. juli 2025. Den introducerer en blanding-ekspert-arkitektur (MoE) i videosiffisjonsmodellen, som forbedrer modellkapacitet og prestasjon betydelig uten å øke inferensiekostene. Modellen er merket for sin filmestetika, høydefinisjonsprodukt 1080p og evnen til å generere komplekse, væskebevegelse med større kontroll enn tidligere modeller.

Lapper komplekse, flytende og naturlige bevegelser i videoer, forbedrer realisme og sammenhæng.

Trent på nøye kurerte data for å produsere videoer med precis kontroll over lys, farge og komposition.

Genererer videoer med nativ 1080p oppløsning ved 24fps, egnet til profesjonell bruk.

Filmkamerastontrol Genererer videoer med nativ 1080p oppløsning ved 24fps, egnet til profesjonell bruk.

Lager sømløse videoovergangen ved å interpolere mellom en angivet start- og endramme.

En høyt komprimert 5B-model er tilgjengelig som kan kjøre på konsument-GPU-er som en RTX 4090.

Modellen er offentlig tilgjengelig, og muliggjør finjustering med Lora og andre samfunnsverktøjer.

Her er tre enkle trinn som hjelper deg å utforske WAN 2.2 på Vizard:

Gå til Vizards tekst til videogenerator og velg WAN 2.2 modellen.

Innstart eller ladd bildet ditt for å starte.

Når videoen er klar, kan du ladde ned den eller dele den på sosiale mediakontoene direkte via Vizard.

Wan2.2 The quality is significantly improved, tested some human body performance. Amazing@Alibaba_Wan #wan2.2 pic.twitter.com/ptUXlOS1Ka

— TTPlanet (@ttplanet) July 28, 2025

Fun workflow I was playing with last night

— A.I.Warper (@AIWarper) August 8, 2025

1) Kontext to remove Thor from the shot

2) Photopea to place Shrek

3) Kontext + Relight lora to blend him into the shot

4) Wan2.2 i2V to animate

Very addicting... 😍

Prompts are written up in the corner. Wan 2.2 prompt below 👇 pic.twitter.com/EnWE2OgA7T

Wan2.2(I2V) works pretty good.(Base image is not AI generated.) pic.twitter.com/5g9CfoiqT4

— Xiu Ran (@f_fanshu) July 30, 2025

You can’t skate here sir..

— Ingi Erlingsson 🪄 (@ingi_erlingsson) August 5, 2025

Wan2.2 @Alibaba_Wan + @ComfyUI 🛹 pic.twitter.com/kFaKeoKYNi

I hope you are enjoying your summer 🍸⛱️

— Julian Bilcke (@flngr) July 28, 2025

Because open source AI video is back 💪

Wan2.2 is out!✨ pic.twitter.com/9feAXVC4Hi

Tried doing a wall punching effect using the new Wan2.2 open source model. @Alibaba_Wan @ComfyUI pic.twitter.com/PGKoZmpuso

— enigmatic_e (@8bit_e) July 31, 2025

Tried the Veo3 annotation trick with Wan2.2 14B, 8 steps pic.twitter.com/x8Lnmcx1wg

— Linoy Tsaban (@linoy_tsaban) July 29, 2025

Hva er WAN 2.2?

WAN 2.2 er en moderne, open source generativ AI videomodell utviklet av Alibabas Damo Academy. Det er en stor oppgradering til den grundlegende WAN-videodelserien, designet for å lage høykvalitete filmvideoer fra tekst- og billedprop. Modellen er kjent for sin avanserte bevegelsesgenerasjon og estetiske kontroller.

Hvilke versjoner er tilgjengelige?

WAN 2.2 er tilgjengelig i flere versjoner med forskjellige funksjoner. Kernmodellene med åpen source inkluderer den effektive TI2V-5B-modellen, som støtter både tekst-til-video (T2V) og bild-til-video (I2V) ved 720p oppløsning og kan kjøre på GPU-er av forbrugerklasse. Det finnes også mer kraftige 14B-modeller, som T2V-A14B og I2V-A14B, som bruker en blanding av eksperter (MoE) arkitektur for overlegen kvalitet og prestasjon, som passer for mer robust hardware.

Hva gjør det unik?

WAN 2.2 står ut på grunn av sin innovative MoE arkitektur, som skiler avlykningsprocessen i spesialiserte stadier for bedre prestasjon uten en betydelig økning i beregningskostnadene. Den har også estetiske kontroller på filmnivå, en evne til å generere komplekse og væskebevegelse og en første-siste ramme til video (FLF2V) funksjon som skaper glatte overganger mellom to bilder. Dens åpen source gir samfunnsdriven finjustering og integrering.

Er det trygt å bruke?

Som en åpen source-model avhenger sikkerheten til WAN 2.2 i høyhet av hvordan den blir implementert og brukt. Utviklere har etableret en brukspolitik som forbyr generering av ulovlig, skadelig eller vildledende innhold. Selv modellen ikke har et inbygget inneholdsmodereringssystem, forventes utviklere og plattformer som bruker WAN 2.2 å implementere sine egne

Hvor raskt er det?

WAN 2.2 er høyt optimert for hastighet, spesielt sin TI2V-5B-modell, som er en av de raskeste tilgjengelige med 720p oppløsning og 24fps. En 5-sekunds video kan genereres på et par minutter på en forbrugerGPU som en RTX 4090, med mer kraftfulle hardwareopp som tilbyr enda raskere resultater. Hastigheten økes ytterligere av sin effektive blanding of-experts (MoE) arkitektur.

Er den tilgængelig via mobil?

WAN 2.2 er hovedsakelig en utviklerfokusert, open source-model. Den har ingen offisiell, spesielt mobilapp fra sin producent. Men fordi den er open source, kan utviklere integreres det i mobilvennlige nettapplikasjoner eller skape egne mobilapplikasjoner. GPU-kompatibiliteten av konsumentklassen gjør den også mer tilgengelig for brugere med høyt end mobile arbeidstasjoner.

Hva kan den skape eller skape?

WAN 2.2 kan generere en bred utvikling av videoinnhold, fra kortformannonser og sosiale medier til filmscener og animasjoner. Muligheten er tekst-til-video, bild-til-video og bild-basert maling. Brukere kan generere videoer med spesifikke kameravegelser, precisere estetiske stiler og realistiske bevegelser for karakter og objekter, som gjør det til et mångsidig verktøj for både tekniske og kreative projekter.

Hvordan kan det brukes?

Den vanligste måten å bruke WAN 2.2 er å ladde ned modelfilene og kjøre dem lokalt på en kompatible maskin, ofte med integrering via plattformer som Comfyui eller diffuser. For en mer tilgængelig opplevelse er modellen tilgjengelig via skloud API-leverandører. Det fins også muligheten til å prøve WAN 2.2 gratis gjennom Vizard plattformen, som gir et online-grænseff til å eksperimentere med modellens muligheter.