New

Der Vermarkter

Leistungen für Ihr Team,

Videos im Skala zu erstellen

Der Schöpfer

Aufbau sozialer Präsenz erleichtert

Die Agentur

Skalier-Videoproduktion mit

einfach

Wan 2.2 ist ein generatives Open-Source-KI-Videomodell der Alibaba Dharma Academy, das am 28. Juli 2025 öffentlich veröffentlicht wurde. Es führt eine Expert Hybrid (MoE) Architektur in das Video-Diffusionsmodell ein, wodurch die Modellkapazität und -leistung erheblich verbessert wird, ohne die Inferenzkosten zu erhöhen. Dieses Modell ist bekannt für seine kinematische Ästhetik, HD-1080p-Ausgabe und die Fähigkeit, komplexe, flüssige Bewegungen zu erzeugen, und bietet bessere Kontrolle als frühere Modelle.

Wan 2.2 ist ein generatives Open-Source-KI-Videomodell der Alibaba Dharma Academy, das am 28. Juli 2025 öffentlich veröffentlicht wurde. Es führt eine Expert Hybrid (MoE) Architektur in das Video-Diffusionsmodell ein, wodurch die Modellkapazität und -leistung erheblich verbessert wird, ohne die Inferenzkosten zu erhöhen. Dieses Modell ist bekannt für seine kinematische Ästhetik, HD-1080p-Ausgabe und die Fähigkeit, komplexe, flüssige Bewegungen zu erzeugen, und bietet bessere Kontrolle als frühere Modelle.

Erstellen Sie komplexe, flüssige und natürliche Bewegungen in Ihren Videos, die Realismus und Kohärenz verbessern.

Erhalten Sie ein sorgfältig kuratiertes Datentraining für präzise Steuerung von Licht, Farbe und Komposition von Videos.

Erzeugt native 1080p-Auflösung Videos mit 24 Bildern pro Sekunde, geeignet für den professionellen Einsatz.

STEUERUNG FÜR KINOMAMERA Erzeugt native 1080p-Auflösung Videos mit 24 Bildern pro Sekunde, geeignet für den professionellen Einsatz.

Erzeugt einen nahtlosen Videoübergang durch Interpolation zwischen den angegebenen Start- und Endframes.

Das hochkomprimierte 5B-Modell kann auf Verbraucher-GPUs wie dem RTX 4090 ausgeführt werden.

Das Modell ist öffentlich verfügbar und ermöglicht eine Feinabstimmung mit LoRA und anderen von der Community entwickelten Tools.

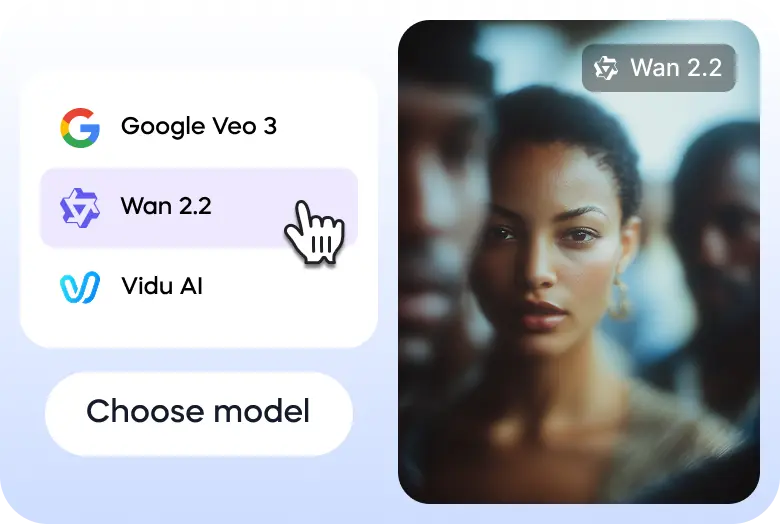

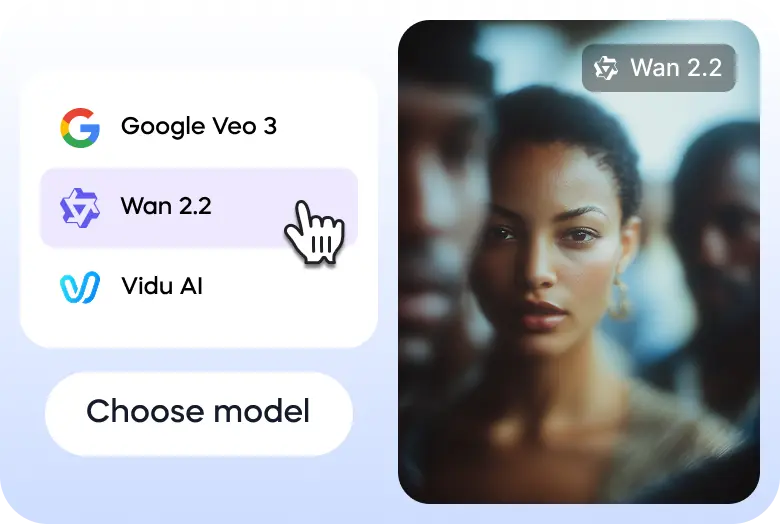

Hier sind drei einfache Schritte, die Ihnen helfen, Wan 2.2 auf Vizard zu erkunden:

Gehen Sie zum Text-zu-Video-Generator von Vizard und wählen Sie das Modell Wan 2.2 aus.

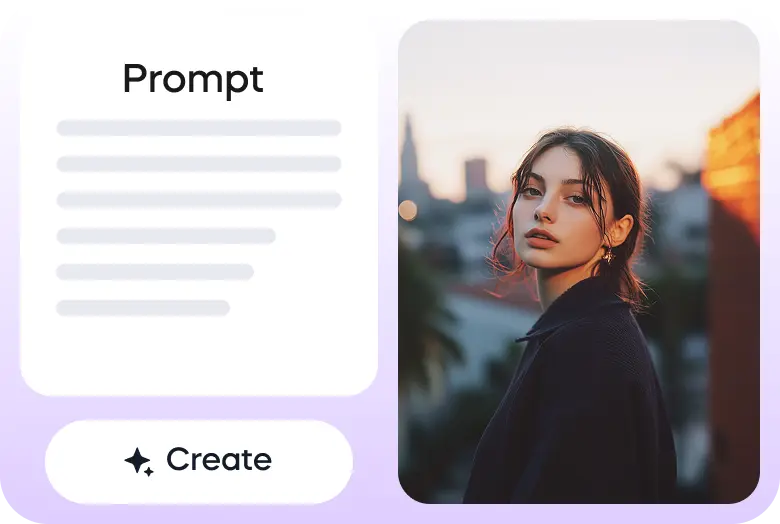

Geben Sie Ihren Tipp ein oder laden Sie Ihr Bild hoch, um zu beginnen.

Sobald das Video fertig ist, kannst du es direkt über Vizard herunterladen oder auf deinen Social-Media-Konten teilen.

Wan2.2 The quality is significantly improved, tested some human body performance. Amazing@Alibaba_Wan #wan2.2 pic.twitter.com/ptUXlOS1Ka

— TTPlanet (@ttplanet) July 28, 2025

Fun workflow I was playing with last night

— A.I.Warper (@AIWarper) August 8, 2025

1) Kontext to remove Thor from the shot

2) Photopea to place Shrek

3) Kontext + Relight lora to blend him into the shot

4) Wan2.2 i2V to animate

Very addicting... 😍

Prompts are written up in the corner. Wan 2.2 prompt below 👇 pic.twitter.com/EnWE2OgA7T

Wan2.2(I2V) works pretty good.(Base image is not AI generated.) pic.twitter.com/5g9CfoiqT4

— Xiu Ran (@f_fanshu) July 30, 2025

You can’t skate here sir..

— Ingi Erlingsson 🪄 (@ingi_erlingsson) August 5, 2025

Wan2.2 @Alibaba_Wan + @ComfyUI 🛹 pic.twitter.com/kFaKeoKYNi

I hope you are enjoying your summer 🍸⛱️

— Julian Bilcke (@flngr) July 28, 2025

Because open source AI video is back 💪

Wan2.2 is out!✨ pic.twitter.com/9feAXVC4Hi

Tried doing a wall punching effect using the new Wan2.2 open source model. @Alibaba_Wan @ComfyUI pic.twitter.com/PGKoZmpuso

— enigmatic_e (@8bit_e) July 31, 2025

Tried the Veo3 annotation trick with Wan2.2 14B, 8 steps pic.twitter.com/x8Lnmcx1wg

— Linoy Tsaban (@linoy_tsaban) July 29, 2025

Was ist Wan 2.2?

Wan 2.2 ist das fortschrittlichste Open-Source-Videomodell für generative künstliche Intelligenz, das von der Alibaba Dharma Academy entwickelt wurde. Dies ist ein bedeutendes Upgrade der Basis-Wan-Videomodell-Serie, die darauf abzielt, qualitativ hochwertige Filmvideos basierend auf Text- und Bildaufforderungen zu erstellen. Das Modell ist bekannt für seine fortschrittliche Bewegungsgeneration und ästhetische Steuerung.

Welche Versionen sind verfügbar?

Es gibt mehrere Versionen von Wan 2.2 mit unterschiedlichen Funktionen. Zu den zentralen Open-Source-Modellen gehört das effiziente TI2V-5B-Modell, das sowohl Text-zu-Video (T2V) als auch Bild-zu-Video (I2V) in 720p-Auflösung unterstützt und auf Verbraucher-GPUs ausgeführt werden kann. Es gibt auch leistungsfähigere 14B-Modelle wie das T2V-A14B und das I2V-A14B, die eine Expert Hybrid (MoE) Architektur für hervorragende Qualität und Leistung nutzen und für robustere Hardware geeignet sind.

Was macht es einzigartig?

Wan 2.2 zeichnet sich durch seine innovative Expert Hybrid (MoE)-Architektur aus, die den Rauschunterdrückungsprozess in spezielle Phasen unterteilt, um eine bessere Leistung zu erzielen, ohne die Rechenkosten wesentlich zu erhöhen. Es verfügt außerdem über ästhetische Kontrollen auf kinematischem Niveau, die in der Lage sind, komplexe und flüssige Bewegungen zu erzeugen, und eine Funktion zum ersten Bild-to-Video (FLF2V), die einen reibungslosen Übergang zwischen zwei Bildern ermöglicht. Seine Open-Source-Natur ermöglicht Community-getriebene Feinabstimmung und Integration.

Ist es sicher zu bedienen?

Als Open-Source-Modell hängt die Sicherheit von Wan 2.2 weitgehend davon ab, wie es implementiert und verwendet wird. Der Entwickler hat eine Nutzungsrichtlinie eingeführt, die die Generierung illegaler, schädlicher oder irreführender Inhalte verbietet. Obwohl das Modell selbst kein integriertes Content-Moderationssystem hat, sollten Entwickler und Plattformen, die Wan 2.2 verwenden, ihre eigenen Sicherheitsmaßnahmen implementieren, um eine verantwortungsvolle Nutzung und die Einhaltung rechtlicher und ethischer Standards zu gewährleisten.

Wie schnell geht es?

Der Wan 2.2 ist hoch für Geschwindigkeit optimiert, insbesondere mit seinem TI2V-5B Modell, das eines der schnellsten bei 720p Auflösung und 24fps ist. Auf einer Verbraucher-GPU wie der RTX 4090 kann ein 5-Sekunden-Video in nur wenigen Minuten generiert werden, und leistungsfähigere Hardware liefert schnellere Ergebnisse. Seine effiziente Expert Hybrid (MoE) Architektur erhöht die Geschwindigkeit weiter.

Ist der Zugriff per Handy möglich?

Wan 2.2 ist in erster Linie ein Entwickler-zentriertes Open-Source-Modell. Es hat keine offizielle dedizierte mobile App von seinem Hersteller. Da es jedoch Open Source ist, können Entwickler es in mobilfreundliche Webanwendungen integrieren oder ihre eigenen mobilen Anwendungen erstellen. Seine Verbraucher-GPU-Kompatibilität macht es auch für Benutzer mit High-End-mobilen Workstations leichter zu verwenden.

Was kann es produzieren oder schaffen?

Wan 2.2 ist in der Lage, eine Vielzahl von Videoinhalten zu generieren, von kurzen Werbeanzeigen und Social-Media-Clips bis hin zu Filmszenen und Animationen. Zu seinen Funktionen gehören Text-zu-Video, Bild-zu-Video und bildbasierte Malerei. Benutzer können Videos mit spezifischen Kamerabewegungen, präzisen ästhetischen Stilen und realistischen Bewegungen von Charakteren und Objekten generieren, was es zu einem vielseitigen Werkzeug für technische und kreative Projekte macht.

Wie benutzt man es?

Die häufigste Möglichkeit, Wan 2.2 zu verwenden, besteht darin, die Modelldateien herunterzuladen und sie auf einem lokal kompatiblen Computer auszuführen, normalerweise integriert über Plattformen wie ComfyUI oder Diffusers. Für eine besser zugängliche Erfahrung ist das Modell über einen Cloud-API-Anbieter verfügbar. Darüber hinaus besteht die Möglichkeit, Wan 2.2 kostenlos über die Vizard-Plattform zu testen, die eine Online-Schnittstelle zum Experimentieren mit den Funktionen des Modells bietet.

Wan 2.2 ist ein generatives Open-Source-KI-Videomodell der Alibaba Dharma Academy, das am 28. Juli 2025 öffentlich veröffentlicht wurde. Es führt eine Expert Hybrid (MoE) Architektur in das Video-Diffusionsmodell ein, wodurch die Modellkapazität und -leistung erheblich verbessert wird, ohne die Inferenzkosten zu erhöhen. Dieses Modell ist bekannt für seine kinematische Ästhetik, HD-1080p-Ausgabe und die Fähigkeit, komplexe, flüssige Bewegungen zu erzeugen, und bietet bessere Kontrolle als frühere Modelle.

Erstellen Sie komplexe, flüssige und natürliche Bewegungen in Ihren Videos, die Realismus und Kohärenz verbessern.

Erhalten Sie ein sorgfältig kuratiertes Datentraining für präzise Steuerung von Licht, Farbe und Komposition von Videos.

Erzeugt native 1080p-Auflösung Videos mit 24 Bildern pro Sekunde, geeignet für den professionellen Einsatz.

STEUERUNG FÜR KINOMAMERA Erzeugt native 1080p-Auflösung Videos mit 24 Bildern pro Sekunde, geeignet für den professionellen Einsatz.

Erzeugt einen nahtlosen Videoübergang durch Interpolation zwischen den angegebenen Start- und Endframes.

Das hochkomprimierte 5B-Modell kann auf Verbraucher-GPUs wie dem RTX 4090 ausgeführt werden.

Das Modell ist öffentlich verfügbar und ermöglicht eine Feinabstimmung mit LoRA und anderen von der Community entwickelten Tools.

Hier sind drei einfache Schritte, die Ihnen helfen, Wan 2.2 auf Vizard zu erkunden:

Gehen Sie zum Text-zu-Video-Generator von Vizard und wählen Sie das Modell Wan 2.2 aus.

Geben Sie Ihren Tipp ein oder laden Sie Ihr Bild hoch, um zu beginnen.

Sobald das Video fertig ist, kannst du es direkt über Vizard herunterladen oder auf deinen Social-Media-Konten teilen.

Wan2.2 The quality is significantly improved, tested some human body performance. Amazing@Alibaba_Wan #wan2.2 pic.twitter.com/ptUXlOS1Ka

— TTPlanet (@ttplanet) July 28, 2025

Fun workflow I was playing with last night

— A.I.Warper (@AIWarper) August 8, 2025

1) Kontext to remove Thor from the shot

2) Photopea to place Shrek

3) Kontext + Relight lora to blend him into the shot

4) Wan2.2 i2V to animate

Very addicting... 😍

Prompts are written up in the corner. Wan 2.2 prompt below 👇 pic.twitter.com/EnWE2OgA7T

Wan2.2(I2V) works pretty good.(Base image is not AI generated.) pic.twitter.com/5g9CfoiqT4

— Xiu Ran (@f_fanshu) July 30, 2025

You can’t skate here sir..

— Ingi Erlingsson 🪄 (@ingi_erlingsson) August 5, 2025

Wan2.2 @Alibaba_Wan + @ComfyUI 🛹 pic.twitter.com/kFaKeoKYNi

I hope you are enjoying your summer 🍸⛱️

— Julian Bilcke (@flngr) July 28, 2025

Because open source AI video is back 💪

Wan2.2 is out!✨ pic.twitter.com/9feAXVC4Hi

Tried doing a wall punching effect using the new Wan2.2 open source model. @Alibaba_Wan @ComfyUI pic.twitter.com/PGKoZmpuso

— enigmatic_e (@8bit_e) July 31, 2025

Tried the Veo3 annotation trick with Wan2.2 14B, 8 steps pic.twitter.com/x8Lnmcx1wg

— Linoy Tsaban (@linoy_tsaban) July 29, 2025

Was ist Wan 2.2?

Wan 2.2 ist das fortschrittlichste Open-Source-Videomodell für generative künstliche Intelligenz, das von der Alibaba Dharma Academy entwickelt wurde. Dies ist ein bedeutendes Upgrade der Basis-Wan-Videomodell-Serie, die darauf abzielt, qualitativ hochwertige Filmvideos basierend auf Text- und Bildaufforderungen zu erstellen. Das Modell ist bekannt für seine fortschrittliche Bewegungsgeneration und ästhetische Steuerung.

Welche Versionen sind verfügbar?

Es gibt mehrere Versionen von Wan 2.2 mit unterschiedlichen Funktionen. Zu den zentralen Open-Source-Modellen gehört das effiziente TI2V-5B-Modell, das sowohl Text-zu-Video (T2V) als auch Bild-zu-Video (I2V) in 720p-Auflösung unterstützt und auf Verbraucher-GPUs ausgeführt werden kann. Es gibt auch leistungsfähigere 14B-Modelle wie das T2V-A14B und das I2V-A14B, die eine Expert Hybrid (MoE) Architektur für hervorragende Qualität und Leistung nutzen und für robustere Hardware geeignet sind.

Was macht es einzigartig?

Wan 2.2 zeichnet sich durch seine innovative Expert Hybrid (MoE)-Architektur aus, die den Rauschunterdrückungsprozess in spezielle Phasen unterteilt, um eine bessere Leistung zu erzielen, ohne die Rechenkosten wesentlich zu erhöhen. Es verfügt außerdem über ästhetische Kontrollen auf kinematischem Niveau, die in der Lage sind, komplexe und flüssige Bewegungen zu erzeugen, und eine Funktion zum ersten Bild-to-Video (FLF2V), die einen reibungslosen Übergang zwischen zwei Bildern ermöglicht. Seine Open-Source-Natur ermöglicht Community-getriebene Feinabstimmung und Integration.

Ist es sicher zu bedienen?

Als Open-Source-Modell hängt die Sicherheit von Wan 2.2 weitgehend davon ab, wie es implementiert und verwendet wird. Der Entwickler hat eine Nutzungsrichtlinie eingeführt, die die Generierung illegaler, schädlicher oder irreführender Inhalte verbietet. Obwohl das Modell selbst kein integriertes Content-Moderationssystem hat, sollten Entwickler und Plattformen, die Wan 2.2 verwenden, ihre eigenen Sicherheitsmaßnahmen implementieren, um eine verantwortungsvolle Nutzung und die Einhaltung rechtlicher und ethischer Standards zu gewährleisten.

Wie schnell geht es?

Der Wan 2.2 ist hoch für Geschwindigkeit optimiert, insbesondere mit seinem TI2V-5B Modell, das eines der schnellsten bei 720p Auflösung und 24fps ist. Auf einer Verbraucher-GPU wie der RTX 4090 kann ein 5-Sekunden-Video in nur wenigen Minuten generiert werden, und leistungsfähigere Hardware liefert schnellere Ergebnisse. Seine effiziente Expert Hybrid (MoE) Architektur erhöht die Geschwindigkeit weiter.

Ist der Zugriff per Handy möglich?

Wan 2.2 ist in erster Linie ein Entwickler-zentriertes Open-Source-Modell. Es hat keine offizielle dedizierte mobile App von seinem Hersteller. Da es jedoch Open Source ist, können Entwickler es in mobilfreundliche Webanwendungen integrieren oder ihre eigenen mobilen Anwendungen erstellen. Seine Verbraucher-GPU-Kompatibilität macht es auch für Benutzer mit High-End-mobilen Workstations leichter zu verwenden.

Was kann es produzieren oder schaffen?

Wan 2.2 ist in der Lage, eine Vielzahl von Videoinhalten zu generieren, von kurzen Werbeanzeigen und Social-Media-Clips bis hin zu Filmszenen und Animationen. Zu seinen Funktionen gehören Text-zu-Video, Bild-zu-Video und bildbasierte Malerei. Benutzer können Videos mit spezifischen Kamerabewegungen, präzisen ästhetischen Stilen und realistischen Bewegungen von Charakteren und Objekten generieren, was es zu einem vielseitigen Werkzeug für technische und kreative Projekte macht.

Wie benutzt man es?

Die häufigste Möglichkeit, Wan 2.2 zu verwenden, besteht darin, die Modelldateien herunterzuladen und sie auf einem lokal kompatiblen Computer auszuführen, normalerweise integriert über Plattformen wie ComfyUI oder Diffusers. Für eine besser zugängliche Erfahrung ist das Modell über einen Cloud-API-Anbieter verfügbar. Darüber hinaus besteht die Möglichkeit, Wan 2.2 kostenlos über die Vizard-Plattform zu testen, die eine Online-Schnittstelle zum Experimentieren mit den Funktionen des Modells bietet.