New

Markedsmand

Styrk dit team til at oprette

videoer i skala

Skapere

Det er lett at opbygge social tilstedeværelse

Agenturet

Skala videoproduktion med

lethed

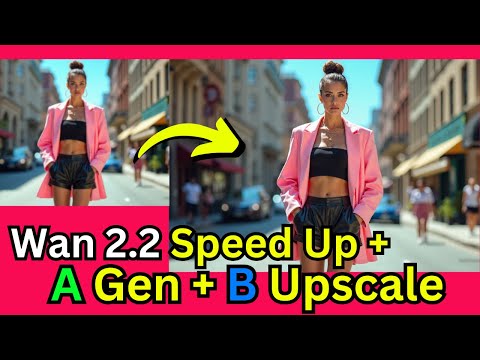

WAN 2.2 er en open-source-generativ AI videomodel fra Alibabas Damo Academy, offentligt udgivet den 28. juli 2025. Den indfører en blanding af eksperter (MoE) arkitektur i videosiffusionsmodellen, som forbedrer modelkapacitet og præstationer betydeligt uden at øge inferenceomkostningerne. Modellen er bemærket for sin filmestetik, højdefinitionsbaseret 1080p output og dens evne til at generere komplekse, flydende bevægelse med større kontrol end tidligere modeller.

WAN 2.2 er en open-source-generativ AI videomodel fra Alibabas Damo Academy, offentligt udgivet den 28. juli 2025. Den indfører en blanding af eksperter (MoE) arkitektur i videosiffusionsmodellen, som forbedrer modelkapacitet og præstationer betydeligt uden at øge inferenceomkostningerne. Modellen er bemærket for sin filmestetik, højdefinitionsbaseret 1080p output og dens evne til at generere komplekse, flydende bevægelse med større kontrol end tidligere modeller.

Skaper komplekse, flydende og naturlige bevægelser i videoer, hvilket forbedrer realisme og sammenhæng.

Trænet på nøje kurerede data til at producere videoer med præcis kontrol over lys, farve og sammensætning.

Genererer videoer med native 1080p opløsning ved 24fps, egnet til professionel brug.

Filmkameraregulering Genererer videoer med native 1080p opløsning ved 24fps, egnet til professionel brug.

Opretter sømløse videoovergange ved at interpolere mellem en angivet start- og endramme.

Der er en højt komprimeret 5B-model, som kan køre på forbrugerGPUer som en RTX 4090.

Modellen er offentligt tilgængelig, hvilket muliggør finjustering med Lora og andre fællesskabsredskaber.

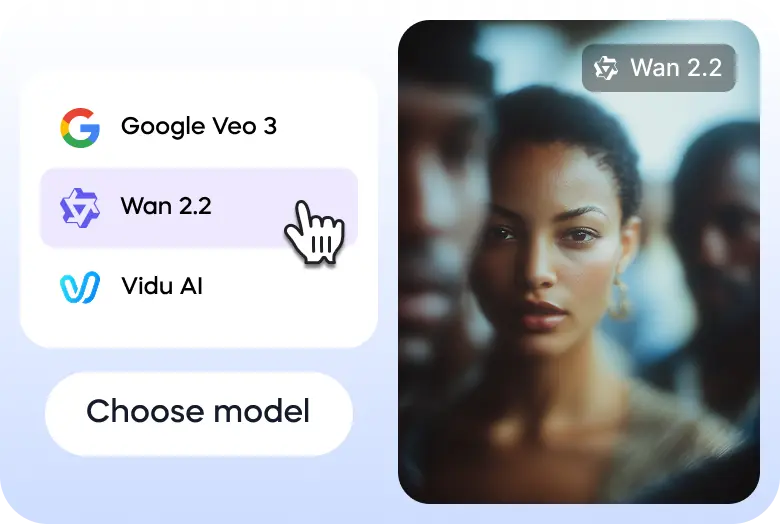

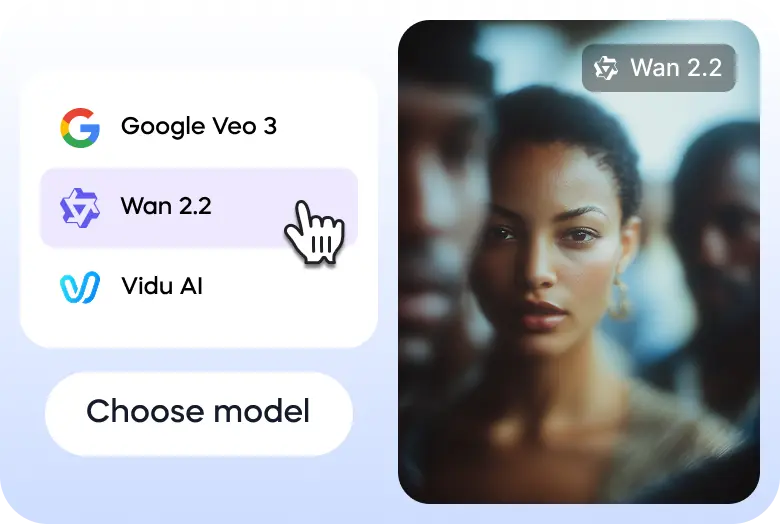

Her er tre enkle trin til at hjælpe dig at undersøge WAN 2.2 på Vizard:

Gå til Vizards tekst til videogenerator og vælg WAN 2. 2 model.

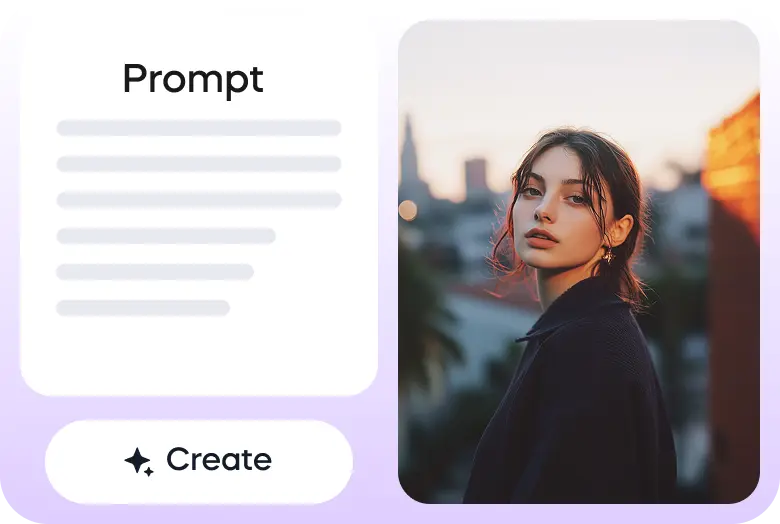

Indtast din anmeldning eller upload dit billede for at starte.

Når videoen er klar, kan du downloade den eller dele den på dine sociale mediakonter direkte via Vizard.

Wan2.2 The quality is significantly improved, tested some human body performance. Amazing@Alibaba_Wan #wan2.2 pic.twitter.com/ptUXlOS1Ka

— TTPlanet (@ttplanet) July 28, 2025

Fun workflow I was playing with last night

— A.I.Warper (@AIWarper) August 8, 2025

1) Kontext to remove Thor from the shot

2) Photopea to place Shrek

3) Kontext + Relight lora to blend him into the shot

4) Wan2.2 i2V to animate

Very addicting... 😍

Prompts are written up in the corner. Wan 2.2 prompt below 👇 pic.twitter.com/EnWE2OgA7T

Wan2.2(I2V) works pretty good.(Base image is not AI generated.) pic.twitter.com/5g9CfoiqT4

— Xiu Ran (@f_fanshu) July 30, 2025

You can’t skate here sir..

— Ingi Erlingsson 🪄 (@ingi_erlingsson) August 5, 2025

Wan2.2 @Alibaba_Wan + @ComfyUI 🛹 pic.twitter.com/kFaKeoKYNi

I hope you are enjoying your summer 🍸⛱️

— Julian Bilcke (@flngr) July 28, 2025

Because open source AI video is back 💪

Wan2.2 is out!✨ pic.twitter.com/9feAXVC4Hi

Tried doing a wall punching effect using the new Wan2.2 open source model. @Alibaba_Wan @ComfyUI pic.twitter.com/PGKoZmpuso

— enigmatic_e (@8bit_e) July 31, 2025

Tried the Veo3 annotation trick with Wan2.2 14B, 8 steps pic.twitter.com/x8Lnmcx1wg

— Linoy Tsaban (@linoy_tsaban) July 29, 2025

Hvad er WAN 2, 2?

WAN 2.2 er en moderne, open-source-generativ AI videomodel udviklet af Alibabas Damo Academy. Det er en stor opgradering af den grundlæggende WAN-videodelserie, der er designet for at skabe filmvideoer af høj kvalitet fra tekst- og billedprompts. Modellen er kendt for sin avancerede bevægelsesgeneration og estetiske kontrol.

Hvilken version er tilgængelige?

WAN 2.2 er tilgængelig i flere versioner med forskellige muligheder. De kerneopensource-modeller omfatter den effektive TI2V-5B-model, som støtter både tekst-til-video (T2V) og billed-til-video (I2V) ved 720p opløsning og kan køre på forbrugerklasse GPUer. Der er også mere kraftige 14B-modeller, såsom T2V-A14B og I2V-A14B, som anvender en blanding af eksperter (MoE) arkitektur for bedre kvalitet og præstation, der er egnet til mere robust hardware.

Hvad gør det enestående?

WAN 2.2 udstedes på grund af sin innovative arkitektur af eksperter (MoE), som adskiller afvisningsprocessen i specialiserede faser for bedre præstationer uden en betydelig stigning i beregningsomkostningerne. Den har også estetisk kontrol på kinematisk niveau, en evne til at generere kompleks og flydende bevægelser og en første-sidste ramme til video (FLF2V) funktion, der skaber glatte overgange mellem to billeder. Denne open-source-karakter giver mulighed for fællesskabsdriven finjustering og integration.

Er det sikkert at anvende?

Som open-source-model afhænger sikkerheden for WAN 2.2 i høj grad af, hvordan den gennemføres og anvendes. Udviklerne har fastsat en anvendelsespolitik, der forbyder generering af ulovligt, skadeligt eller vildledende indhold. Selv om modellen ikke har et indbygget indholdsmoderationssystem, forventes udviklere og platforme, der anvender WAN 2.2, at gennemføre deres egne sikkerhedsforanstaltninger for at sikre ansvarlig anvendelse og overholdelse af retlige og etiske standarder.

Hvor hurtigt er det?

WAN 2.2 er meget optimeret for hastighed, især sin Ti2V-5B-model, som er en af de hurtigste tilgængelige ved 720p opløsning og 24fps. En 5-sekunds video kan genereres på blot få minutter på en forbrugerGPU som en RTX 4090, med mere kraftig hardware, der giver endnu hurtigere resultater. Hastigheden øges yderligere af dens effektive arkitektur af eksperter (MoE).

Er det tilgængelig via mobil?

WAN 2.2 er primært en udviklerfokuseret, open-source-model. Den har ikke en officiel, specialiseret mobilapp fra sin producent. Da det er open source, kan udviklere imidlertid integreres det i mobilvenlige webapplikationer eller oprette deres egne mobilapplikationer. Dens GPU-kompatibilitet i forbrugerklasse gør den også mere tilgængelig for brugere med mobile arbejdsstationer.

Hvad kan den generere eller skabe?

WAN 2.2 er i stand til at generere en lang række videoindhold, fra kortformige reklamer og sociale medier til filmscener og animationer. Dens muligheder omfatter tekst-til-video, billed-til-video og billedbaseret in-maling. Brugerne kan generere videoer med specifikke kameravægelser, præcise estetiske stiler og realistisk bevægelse af tegn og objekter, hvilket gør det til et mångsidigt værktøj til både tekniske og kreative projekter.

Hvordan kan det anvendes?

Den mest almindelige måde at bruge WAN 2.2 er ved at downloade modelfilerne og køre dem lokalt på en kompatible maskin, ofte med integration gennem platforme som Comfyui eller diffuser. For en mere tilgængelig erfaring er modellen tilgængelig via cloud API-leverandører. Der er også mulighed for at prøve WAN 2.2 gratis gennem Vizard-platformen, som giver en online-grænseflader til at forsøge med modellens muligheder.

WAN 2.2 er en open-source-generativ AI videomodel fra Alibabas Damo Academy, offentligt udgivet den 28. juli 2025. Den indfører en blanding af eksperter (MoE) arkitektur i videosiffusionsmodellen, som forbedrer modelkapacitet og præstationer betydeligt uden at øge inferenceomkostningerne. Modellen er bemærket for sin filmestetik, højdefinitionsbaseret 1080p output og dens evne til at generere komplekse, flydende bevægelse med større kontrol end tidligere modeller.

Skaper komplekse, flydende og naturlige bevægelser i videoer, hvilket forbedrer realisme og sammenhæng.

Trænet på nøje kurerede data til at producere videoer med præcis kontrol over lys, farve og sammensætning.

Genererer videoer med native 1080p opløsning ved 24fps, egnet til professionel brug.

Filmkameraregulering Genererer videoer med native 1080p opløsning ved 24fps, egnet til professionel brug.

Opretter sømløse videoovergange ved at interpolere mellem en angivet start- og endramme.

Der er en højt komprimeret 5B-model, som kan køre på forbrugerGPUer som en RTX 4090.

Modellen er offentligt tilgængelig, hvilket muliggør finjustering med Lora og andre fællesskabsredskaber.

Her er tre enkle trin til at hjælpe dig at undersøge WAN 2.2 på Vizard:

Gå til Vizards tekst til videogenerator og vælg WAN 2. 2 model.

Indtast din anmeldning eller upload dit billede for at starte.

Når videoen er klar, kan du downloade den eller dele den på dine sociale mediakonter direkte via Vizard.

Wan2.2 The quality is significantly improved, tested some human body performance. Amazing@Alibaba_Wan #wan2.2 pic.twitter.com/ptUXlOS1Ka

— TTPlanet (@ttplanet) July 28, 2025

Fun workflow I was playing with last night

— A.I.Warper (@AIWarper) August 8, 2025

1) Kontext to remove Thor from the shot

2) Photopea to place Shrek

3) Kontext + Relight lora to blend him into the shot

4) Wan2.2 i2V to animate

Very addicting... 😍

Prompts are written up in the corner. Wan 2.2 prompt below 👇 pic.twitter.com/EnWE2OgA7T

Wan2.2(I2V) works pretty good.(Base image is not AI generated.) pic.twitter.com/5g9CfoiqT4

— Xiu Ran (@f_fanshu) July 30, 2025

You can’t skate here sir..

— Ingi Erlingsson 🪄 (@ingi_erlingsson) August 5, 2025

Wan2.2 @Alibaba_Wan + @ComfyUI 🛹 pic.twitter.com/kFaKeoKYNi

I hope you are enjoying your summer 🍸⛱️

— Julian Bilcke (@flngr) July 28, 2025

Because open source AI video is back 💪

Wan2.2 is out!✨ pic.twitter.com/9feAXVC4Hi

Tried doing a wall punching effect using the new Wan2.2 open source model. @Alibaba_Wan @ComfyUI pic.twitter.com/PGKoZmpuso

— enigmatic_e (@8bit_e) July 31, 2025

Tried the Veo3 annotation trick with Wan2.2 14B, 8 steps pic.twitter.com/x8Lnmcx1wg

— Linoy Tsaban (@linoy_tsaban) July 29, 2025

Hvad er WAN 2, 2?

WAN 2.2 er en moderne, open-source-generativ AI videomodel udviklet af Alibabas Damo Academy. Det er en stor opgradering af den grundlæggende WAN-videodelserie, der er designet for at skabe filmvideoer af høj kvalitet fra tekst- og billedprompts. Modellen er kendt for sin avancerede bevægelsesgeneration og estetiske kontrol.

Hvilken version er tilgængelige?

WAN 2.2 er tilgængelig i flere versioner med forskellige muligheder. De kerneopensource-modeller omfatter den effektive TI2V-5B-model, som støtter både tekst-til-video (T2V) og billed-til-video (I2V) ved 720p opløsning og kan køre på forbrugerklasse GPUer. Der er også mere kraftige 14B-modeller, såsom T2V-A14B og I2V-A14B, som anvender en blanding af eksperter (MoE) arkitektur for bedre kvalitet og præstation, der er egnet til mere robust hardware.

Hvad gør det enestående?

WAN 2.2 udstedes på grund af sin innovative arkitektur af eksperter (MoE), som adskiller afvisningsprocessen i specialiserede faser for bedre præstationer uden en betydelig stigning i beregningsomkostningerne. Den har også estetisk kontrol på kinematisk niveau, en evne til at generere kompleks og flydende bevægelser og en første-sidste ramme til video (FLF2V) funktion, der skaber glatte overgange mellem to billeder. Denne open-source-karakter giver mulighed for fællesskabsdriven finjustering og integration.

Er det sikkert at anvende?

Som open-source-model afhænger sikkerheden for WAN 2.2 i høj grad af, hvordan den gennemføres og anvendes. Udviklerne har fastsat en anvendelsespolitik, der forbyder generering af ulovligt, skadeligt eller vildledende indhold. Selv om modellen ikke har et indbygget indholdsmoderationssystem, forventes udviklere og platforme, der anvender WAN 2.2, at gennemføre deres egne sikkerhedsforanstaltninger for at sikre ansvarlig anvendelse og overholdelse af retlige og etiske standarder.

Hvor hurtigt er det?

WAN 2.2 er meget optimeret for hastighed, især sin Ti2V-5B-model, som er en af de hurtigste tilgængelige ved 720p opløsning og 24fps. En 5-sekunds video kan genereres på blot få minutter på en forbrugerGPU som en RTX 4090, med mere kraftig hardware, der giver endnu hurtigere resultater. Hastigheden øges yderligere af dens effektive arkitektur af eksperter (MoE).

Er det tilgængelig via mobil?

WAN 2.2 er primært en udviklerfokuseret, open-source-model. Den har ikke en officiel, specialiseret mobilapp fra sin producent. Da det er open source, kan udviklere imidlertid integreres det i mobilvenlige webapplikationer eller oprette deres egne mobilapplikationer. Dens GPU-kompatibilitet i forbrugerklasse gør den også mere tilgængelig for brugere med mobile arbejdsstationer.

Hvad kan den generere eller skabe?

WAN 2.2 er i stand til at generere en lang række videoindhold, fra kortformige reklamer og sociale medier til filmscener og animationer. Dens muligheder omfatter tekst-til-video, billed-til-video og billedbaseret in-maling. Brugerne kan generere videoer med specifikke kameravægelser, præcise estetiske stiler og realistisk bevægelse af tegn og objekter, hvilket gør det til et mångsidigt værktøj til både tekniske og kreative projekter.

Hvordan kan det anvendes?

Den mest almindelige måde at bruge WAN 2.2 er ved at downloade modelfilerne og køre dem lokalt på en kompatible maskin, ofte med integration gennem platforme som Comfyui eller diffuser. For en mere tilgængelig erfaring er modellen tilgængelig via cloud API-leverandører. Der er også mulighed for at prøve WAN 2.2 gratis gennem Vizard-platformen, som giver en online-grænseflader til at forsøge med modellens muligheder.