New

按平台

Wan 2.2是阿里巴巴达摩院的开源生成式AI视频模型,于2025年7月28日公开发布。它在视频扩散模型中引入了专家混合(MoE)架构,在不增加推理成本的情况下显著增强了模型容量和性能。该模型以其电影级美学、高清1080p输出以及生成复杂、流畅运动的能力而闻名,并且比以前的模型具有更好的控制力。

Wan 2.2是阿里巴巴达摩院的开源生成式AI视频模型,于2025年7月28日公开发布。它在视频扩散模型中引入了专家混合(MoE)架构,在不增加推理成本的情况下显著增强了模型容量和性能。该模型以其电影级美学、高清1080p输出以及生成复杂、流畅运动的能力而闻名,并且比以前的模型具有更好的控制力。

在视频中创建复杂、流畅和自然的动作,提高真实感和连贯性。

接受精心策划的数据培训,可精确控制灯光、色彩和构图的视频。

以24fps的速度生成原生1080p分辨率的视频,适合专业使用。

电影摄影机控制 以24fps的速度生成原生1080p分辨率的视频,适合专业使用。

通过在指定的开始帧和结束帧之间进行插值来创建无缝视频过渡。

高度压缩的5B型号可以在RTX 4090等消费级GPU上运行。

该模型是公开可用的,允许使用LoRA和其他社区开发的工具进行微调。

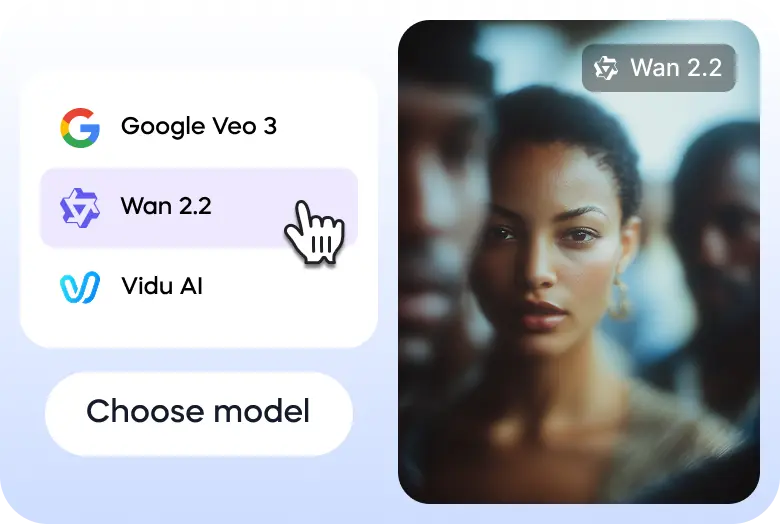

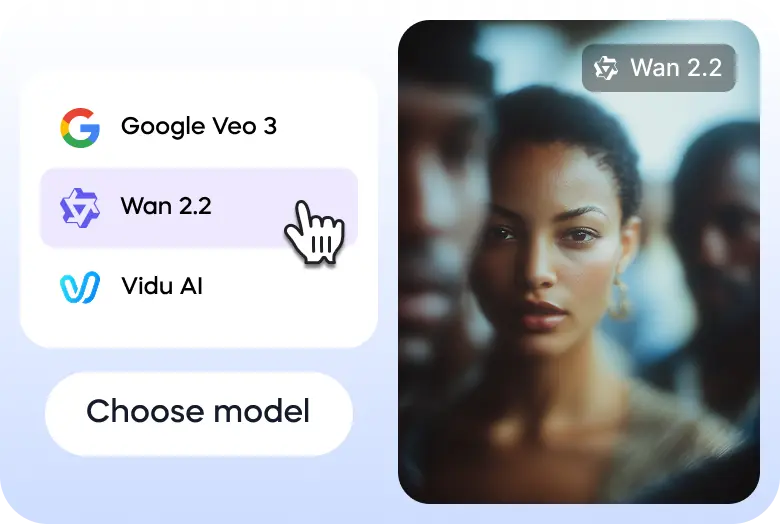

以下是帮助您在Vizard上探索Wan 2.2的三个简单步骤:

转到Vizard的文本到视频生成器,选择Wan 2.2型号。

输入您的提示或上传您的图像开始。

一旦视频准备好了,你可以直接通过Vizard下载或分享到你的社交媒体账户上。

Wan2.2 The quality is significantly improved, tested some human body performance. Amazing@Alibaba_Wan #wan2.2 pic.twitter.com/ptUXlOS1Ka

— TTPlanet (@ttplanet) July 28, 2025

Fun workflow I was playing with last night

— A.I.Warper (@AIWarper) August 8, 2025

1) Kontext to remove Thor from the shot

2) Photopea to place Shrek

3) Kontext + Relight lora to blend him into the shot

4) Wan2.2 i2V to animate

Very addicting... 😍

Prompts are written up in the corner. Wan 2.2 prompt below 👇 pic.twitter.com/EnWE2OgA7T

Wan2.2(I2V) works pretty good.(Base image is not AI generated.) pic.twitter.com/5g9CfoiqT4

— Xiu Ran (@f_fanshu) July 30, 2025

You can’t skate here sir..

— Ingi Erlingsson 🪄 (@ingi_erlingsson) August 5, 2025

Wan2.2 @Alibaba_Wan + @ComfyUI 🛹 pic.twitter.com/kFaKeoKYNi

I hope you are enjoying your summer 🍸⛱️

— Julian Bilcke (@flngr) July 28, 2025

Because open source AI video is back 💪

Wan2.2 is out!✨ pic.twitter.com/9feAXVC4Hi

Tried doing a wall punching effect using the new Wan2.2 open source model. @Alibaba_Wan @ComfyUI pic.twitter.com/PGKoZmpuso

— enigmatic_e (@8bit_e) July 31, 2025

Tried the Veo3 annotation trick with Wan2.2 14B, 8 steps pic.twitter.com/x8Lnmcx1wg

— Linoy Tsaban (@linoy_tsaban) July 29, 2025

什么是Wan 2.2?

Wan 2.2是阿里巴巴达摩院开发的最先进的开源生成式人工智能视频模型。这是对基础Wan视频模型系列的重大升级,旨在根据文本和图像提示创建高质量的电影视频。该模型以其先进的运动生成和美学控制而闻名。

有哪些版本可用?

Wan 2.2有几个版本,具有不同的功能。核心开源模型包括高效的TI2V-5B模型,该模型同时支持720p分辨率的文本到视频(T2V)和图像到视频(I2V),可以在消费级GPU上运行。还有更强大的14B型号,如T2V-A14B和I2V-A14B,它们使用专家混合(MoE)架构,以获得卓越的质量和性能,适合更健壮的硬件。

是什么让它独一无二?

Wan 2.2因其创新的专家混合(MoE)架构而脱颖而出,该架构将去噪过程分为专门的阶段,以获得更好的性能,而不会显著增加计算成本。它还具有电影级的美学控制,能够生成复杂和流畅的运动,以及在两个图像之间创建平滑过渡的倒数第一帧到视频(FLF2V)功能。它的开源性质允许社区驱动的微调和集成。

使用安全吗?

作为一个开源模型,Wan 2.2的安全性很大程度上取决于它是如何实现和使用的。开发人员已经制定了使用政策,禁止生成非法、有害或误导性的内容。虽然该模型本身没有内置的内容审核系统,但使用Wan 2.2的开发人员和平台应该实施自己的安全措施,以确保负责任的使用并遵守法律和道德标准。

速度有多快?

Wan 2.2针对速度进行了高度优化,尤其是其TI2V-5B型号,这是720p分辨率和24fps下最快的型号之一。在RTX 4090这样的消费级GPU上,只需几分钟就可以生成5秒的视频,更强大的硬件可以提供更快的结果。其高效的专家混合(MoE)架构进一步提高了速度。

可以通过手机访问吗?

Wan 2.2主要是一个以开发人员为中心的开源模型。它没有来自其生产商的官方专用移动应用程序。然而,因为它是开源的,开发人员可以将它集成到移动友好的web应用程序中,或者创建自己的移动应用程序。它的消费级GPU兼容性也使它更容易被拥有高端移动工作站的用户使用。

它能产生或创造什么?

Wan 2.2能够生成各种各样的视频内容,从短片广告和社交媒体剪辑到电影场景和动画。它的功能包括文本到视频、图像到视频和基于图像的绘画。用户可以生成具有特定摄像机运动、精确美学风格以及角色和物体逼真运动的视频,使其成为技术和创意项目的多功能工具。

怎么用?

使用Wan 2.2最常见的方法是下载模型文件并在本地兼容机器上运行它们,通常通过ComfyUI或Diffusers等平台进行集成。为了获得更易于访问的体验,该模型可通过云API提供商获得。还有机会通过Vizard平台免费试用Wan 2.2,该平台提供了一个用于试验该模型功能的在线界面。

Wan 2.2是阿里巴巴达摩院的开源生成式AI视频模型,于2025年7月28日公开发布。它在视频扩散模型中引入了专家混合(MoE)架构,在不增加推理成本的情况下显著增强了模型容量和性能。该模型以其电影级美学、高清1080p输出以及生成复杂、流畅运动的能力而闻名,并且比以前的模型具有更好的控制力。

在视频中创建复杂、流畅和自然的动作,提高真实感和连贯性。

接受精心策划的数据培训,可精确控制灯光、色彩和构图的视频。

以24fps的速度生成原生1080p分辨率的视频,适合专业使用。

电影摄影机控制 以24fps的速度生成原生1080p分辨率的视频,适合专业使用。

通过在指定的开始帧和结束帧之间进行插值来创建无缝视频过渡。

高度压缩的5B型号可以在RTX 4090等消费级GPU上运行。

该模型是公开可用的,允许使用LoRA和其他社区开发的工具进行微调。

以下是帮助您在Vizard上探索Wan 2.2的三个简单步骤:

转到Vizard的文本到视频生成器,选择Wan 2.2型号。

输入您的提示或上传您的图像开始。

一旦视频准备好了,你可以直接通过Vizard下载或分享到你的社交媒体账户上。

Wan2.2 The quality is significantly improved, tested some human body performance. Amazing@Alibaba_Wan #wan2.2 pic.twitter.com/ptUXlOS1Ka

— TTPlanet (@ttplanet) July 28, 2025

Fun workflow I was playing with last night

— A.I.Warper (@AIWarper) August 8, 2025

1) Kontext to remove Thor from the shot

2) Photopea to place Shrek

3) Kontext + Relight lora to blend him into the shot

4) Wan2.2 i2V to animate

Very addicting... 😍

Prompts are written up in the corner. Wan 2.2 prompt below 👇 pic.twitter.com/EnWE2OgA7T

Wan2.2(I2V) works pretty good.(Base image is not AI generated.) pic.twitter.com/5g9CfoiqT4

— Xiu Ran (@f_fanshu) July 30, 2025

You can’t skate here sir..

— Ingi Erlingsson 🪄 (@ingi_erlingsson) August 5, 2025

Wan2.2 @Alibaba_Wan + @ComfyUI 🛹 pic.twitter.com/kFaKeoKYNi

I hope you are enjoying your summer 🍸⛱️

— Julian Bilcke (@flngr) July 28, 2025

Because open source AI video is back 💪

Wan2.2 is out!✨ pic.twitter.com/9feAXVC4Hi

Tried doing a wall punching effect using the new Wan2.2 open source model. @Alibaba_Wan @ComfyUI pic.twitter.com/PGKoZmpuso

— enigmatic_e (@8bit_e) July 31, 2025

Tried the Veo3 annotation trick with Wan2.2 14B, 8 steps pic.twitter.com/x8Lnmcx1wg

— Linoy Tsaban (@linoy_tsaban) July 29, 2025

什么是Wan 2.2?

Wan 2.2是阿里巴巴达摩院开发的最先进的开源生成式人工智能视频模型。这是对基础Wan视频模型系列的重大升级,旨在根据文本和图像提示创建高质量的电影视频。该模型以其先进的运动生成和美学控制而闻名。

有哪些版本可用?

Wan 2.2有几个版本,具有不同的功能。核心开源模型包括高效的TI2V-5B模型,该模型同时支持720p分辨率的文本到视频(T2V)和图像到视频(I2V),可以在消费级GPU上运行。还有更强大的14B型号,如T2V-A14B和I2V-A14B,它们使用专家混合(MoE)架构,以获得卓越的质量和性能,适合更健壮的硬件。

是什么让它独一无二?

Wan 2.2因其创新的专家混合(MoE)架构而脱颖而出,该架构将去噪过程分为专门的阶段,以获得更好的性能,而不会显著增加计算成本。它还具有电影级的美学控制,能够生成复杂和流畅的运动,以及在两个图像之间创建平滑过渡的倒数第一帧到视频(FLF2V)功能。它的开源性质允许社区驱动的微调和集成。

使用安全吗?

作为一个开源模型,Wan 2.2的安全性很大程度上取决于它是如何实现和使用的。开发人员已经制定了使用政策,禁止生成非法、有害或误导性的内容。虽然该模型本身没有内置的内容审核系统,但使用Wan 2.2的开发人员和平台应该实施自己的安全措施,以确保负责任的使用并遵守法律和道德标准。

速度有多快?

Wan 2.2针对速度进行了高度优化,尤其是其TI2V-5B型号,这是720p分辨率和24fps下最快的型号之一。在RTX 4090这样的消费级GPU上,只需几分钟就可以生成5秒的视频,更强大的硬件可以提供更快的结果。其高效的专家混合(MoE)架构进一步提高了速度。

可以通过手机访问吗?

Wan 2.2主要是一个以开发人员为中心的开源模型。它没有来自其生产商的官方专用移动应用程序。然而,因为它是开源的,开发人员可以将它集成到移动友好的web应用程序中,或者创建自己的移动应用程序。它的消费级GPU兼容性也使它更容易被拥有高端移动工作站的用户使用。

它能产生或创造什么?

Wan 2.2能够生成各种各样的视频内容,从短片广告和社交媒体剪辑到电影场景和动画。它的功能包括文本到视频、图像到视频和基于图像的绘画。用户可以生成具有特定摄像机运动、精确美学风格以及角色和物体逼真运动的视频,使其成为技术和创意项目的多功能工具。

怎么用?

使用Wan 2.2最常见的方法是下载模型文件并在本地兼容机器上运行它们,通常通过ComfyUI或Diffusers等平台进行集成。为了获得更易于访问的体验,该模型可通过云API提供商获得。还有机会通过Vizard平台免费试用Wan 2.2,该平台提供了一个用于试验该模型功能的在线界面。